Daha önce ( Bölüm -1 ) Oracle Linux 8 üzerinde , Oracle Database 19C Real Application Clusters kurulumunun işletim sistemini hazırlamıştık. Bugünkü yazımızda Real Application Cluster & Grid Ortamının Hazırlayıp, kurulum adımlarını işleyeceğiz.

Bilgilerimizi kısaca tazelemek gerekirse, öncelikle işletim sistemini kurmuştuk ve arkasından network ayarlarımızı yaparak iki işletim sistemini public ve private ip adresleri üzerinden konuşturmuştuk. Şimdi Disk yapılandırmalarını yapacağız.

Ben test kurulumu yaptığım için dört disk ile çalışacağım. Bu disklerin iki tanesi +DATA için diğer iki tanesi +FRA için kullanılacak.

Disklerimi inceliyorum, Çalıştığım hypervisor ortamında disklerim SD ile başlamakta. Sizin ortamında SD* ile başlamayabilir. Duruma göre düzeltebilirsiniz.

SDB , SDC , SDD ve SDE paylaşımlı olarak eklediğim diskler. ASM burada çalışacak

[root@node1 ~]# ll /dev/sd*

brw-rw----. 1 root disk 8, 0 Sep 13 13:04 /dev/sda

brw-rw----. 1 root disk 8, 1 Sep 13 13:04 /dev/sda1

brw-rw----. 1 root disk 8, 2 Sep 13 13:04 /dev/sda2

brw-rw----. 1 root disk 8, 16 Sep 13 13:04 /dev/sdb

brw-rw----. 1 root disk 8, 32 Sep 13 13:04 /dev/sdc

brw-rw----. 1 root disk 8, 48 Sep 13 13:04 /dev/sdd

brw-rw----. 1 root disk 8, 64 Sep 13 13:04 /dev/sdeDiskleri hazırlayacağım. Sonrasına Oracle ASM ile devam edeceğiz.

Aşağıdaki işlemi NODE1 üzerinden yapıyorum. ( NODE2 üzerinde işlem yapılmaması gerekiyor )

[root@node1 ~]# fdisk /dev/sdb

Welcome to fdisk (util-linux 2.32.1).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table.

Created a new DOS disklabel with disk identifier 0xf2177cca.

Command (m for help): n

Partition type

p primary (0 primary, 0 extended, 4 free)

e extended (container for logical partitions)

Select (default p): p

Partition number (1-4, default 1): 1

First sector (2048-20971519, default 2048):

Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519):

Created a new partition 1 of type 'Linux' and of size 10 GiB.

Command (m for help): w

The partition table has been altered.

Calling ioctl() to re-read partition table.

Syncing disks.

Bu işlemleri diğer disklerimiz ( sdc , sdd , sde ) için gerçekleştiriyoruz. İşlerimiz bittikten sonra aşağıdaki gibi bir çıktı olacak.

[root@node1 ~]# ll /dev/sd*

brw-rw----. 1 root disk 8, 0 Sep 13 13:04 /dev/sda

brw-rw----. 1 root disk 8, 1 Sep 13 13:04 /dev/sda1

brw-rw----. 1 root disk 8, 2 Sep 13 13:04 /dev/sda2

brw-rw----. 1 root disk 8, 16 Sep 13 13:07 /dev/sdb

brw-rw----. 1 root disk 8, 17 Sep 13 13:07 /dev/sdb1

brw-rw----. 1 root disk 8, 32 Sep 13 13:07 /dev/sdc

brw-rw----. 1 root disk 8, 33 Sep 13 13:07 /dev/sdc1

brw-rw----. 1 root disk 8, 48 Sep 13 13:07 /dev/sdd

brw-rw----. 1 root disk 8, 49 Sep 13 13:07 /dev/sdd1

brw-rw----. 1 root disk 8, 64 Sep 13 13:07 /dev/sde

brw-rw----. 1 root disk 8, 65 Sep 13 13:07 /dev/sde1

NODE1 ve NODE2 sunucularını yeniden başlatıyoruz. Bundan sonraki adımda disklermizi ASM için hazırlayacağız.

Aşağıdaki işlemleri NODE1 ve NODE2 için uyguluyoruz.

[root@node1 ~]# oracleasm update-driver

Kernel: 5.4.17-2011.5.3.el8uek.x86_64 x86_64

Driver name: oracleasm-5.4.17-2011.5.3.el8uek.x86_64

Driver for kernel 5.4.17-2011.5.3.el8uek.x86_64 does not exist[root@node2 ~]# oracleasm update-driver

Kernel: 5.4.17-2011.5.3.el8uek.x86_64 x86_64

Driver name: oracleasm-5.4.17-2011.5.3.el8uek.x86_64

Driver for kernel 5.4.17-2011.5.3.el8uek.x86_64 does not exist[root@node1 ~]# oracleasm configure -I

Configuring the Oracle ASM library driver.

This will configure the on-boot properties of the Oracle ASM library

driver. The following questions will determine whether the driver is

loaded on boot and what permissions it will have. The current values

will be shown in brackets ('[]'). Hitting <ENTER> without typing an

answer will keep that current value. Ctrl-C will abort.

Default user to own the driver interface []: grid

Default group to own the driver interface []: asmadmin

Start Oracle ASM library driver on boot (y/n) [n]: y

Scan for Oracle ASM disks on boot (y/n) [y]: y

The next two configuration options take substrings to match device names.

The substring "sd" (without the quotes), for example, matches "sda", "sdb",

etc. You may enter more than one substring pattern, separated by spaces.

The special string "none" (again, without the quotes) will clear the value.

Device order to scan for ASM disks []:

Devices to exclude from scanning []:

Directories to scan []:

Use device logical block size for ASM (y/n) [n]: y

Writing Oracle ASM library driver configuration: done[root@node2 ~]# oracleasm configure -I

Configuring the Oracle ASM library driver.

This will configure the on-boot properties of the Oracle ASM library

driver. The following questions will determine whether the driver is

loaded on boot and what permissions it will have. The current values

will be shown in brackets ('[]'). Hitting <ENTER> without typing an

answer will keep that current value. Ctrl-C will abort.

Default user to own the driver interface []: grid

Default group to own the driver interface []: asmadmin

Start Oracle ASM library driver on boot (y/n) [n]: y

Scan for Oracle ASM disks on boot (y/n) [y]: y

The next two configuration options take substrings to match device names.

The substring "sd" (without the quotes), for example, matches "sda", "sdb",

etc. You may enter more than one substring pattern, separated by spaces.

The special string "none" (again, without the quotes) will clear the value.

Device order to scan for ASM disks []:

Devices to exclude from scanning []:

Directories to scan []:

Use device logical block size for ASM (y/n) [n]: y

Writing Oracle ASM library driver configuration: doneDisklerimiz hemen hemen hazırlandı. oracleasm init ile kerneli aktif hale getirip mühürleme işlemini yapacağız.

NODE1 ve NODE2 sunucularında kerneli aktif hale getiriyoruz.

[root@node1 ~]# oracleasm init

Creating /dev/oracleasm mount point: /dev/oracleasm

Loading module "oracleasm": oracleasm

Configuring "oracleasm" to use device logical block size

Mounting ASMlib driver filesystem: /dev/oracleasm[root@node2 ~]# oracleasm init

Creating /dev/oracleasm mount point: /dev/oracleasm

Loading module "oracleasm": oracleasm

Configuring "oracleasm" to use device logical block size

Mounting ASMlib driver filesystem: /dev/oracleasmDiskleri damgalama işlemini yapacağız. Bu işlemi sadece NODE1 üzerinde yapıyoruz.

[root@node1 ~]# oracleasm createdisk data1 /dev/sdb1

Writing disk header: done

Instantiating disk: done

[root@node1 ~]# oracleasm createdisk data2 /dev/sdc11

Writing disk header: done

Instantiating disk: done

[root@node1 ~]# oracleasm createdisk fra1 /dev/sdd1

Writing disk header: done

Instantiating disk: done

[root@node1 ~]# oracleasm createdisk fra2 /dev/sde1

Writing disk header: done

Instantiating disk: doneDisklerimizi kontrol ediyoruz.

[root@node1 ~]# ll /dev/oracleasm/disks/

total 0

brw-rw---- 1 oracle dba 259, 5 Sep 13 02:38 DATA1

brw-rw---- 1 oracle dba 259, 7 Sep 13 02:38 DATA2

brw-rw---- 1 oracle dba 259, 11 Sep 13 02:39 FRA1

brw-rw---- 1 oracle dba 259, 9 Sep 13 02:38 FRA2Yaptığımız işlemin NODE2 üzerinde görünmesi için aşağıdaki komutu çalıştırıyoruz.

[root@node2 ~]# oracleasm scandisks

Reloading disk partitions: done

Cleaning any stale ASM disks...

Scanning system for ASM disks...

Instantiating disk "DATA1"

Instantiating disk "DATA2"

Instantiating disk "FRA1"

Instantiating disk "FRA2"Disklerimiz şuan hazır. Artık kuruluma başlayabiliriz. Öncelikle Grid kurulumu yapacağız.

# cp V982068-01.zip /u01/app/grid/19.3.0/gridhome_1

# cd /u01/app/grid/19.3.0/gridhome_1

# chown grid:oinstall V982068-01.zip

# su – grid

# cd /u01/app/grid/19.3.0/gridhome_1

$ unzip V982068-01.zipDosyalarımız kopyalandı. Şimdi kurulum başlıyor.

Önemli not : Eğer OEL 8.2 üzerinde kurulum yapıyorsanız, Oracle Database 19C şuan bu sürüme resmi destek vermiyor. Aşağıdaki parametreyi set etmeniz gerekecektir.

# su - grid

$ export CV_ASSUME_DISTID=OEL8.1

$ cd /$GRID_HOME/

$ ./grid_Setup.shYeni bir Cluster oluşturacağımız için ” Configure an Oracle Standalone Cluster ” diyoruz.

Cluster Name ve Scan Name bilgilerimizi giriyoruz.

İkinci sunucumuzu ekliyoruz.

Ekleme işleminden sonra iki sunucunun birbiri ile konuşması gerekiyor.Bunun için SSH kullanacağız.

Sistem bu aşamada birbiri ile ” GRID ” kullanıcısı ile konuşacak. Grid kullanıcımızın şifresini giriyoruz.

Network bilgilerini girmemiz gerekiyor. Aşağıdaki gibi ayarlıyoruz.

Kurulum eklediğimiz 4 adet ASM disk üzerine olacak. ” Use Oracle Flex ASM for storage ” diyoruz.

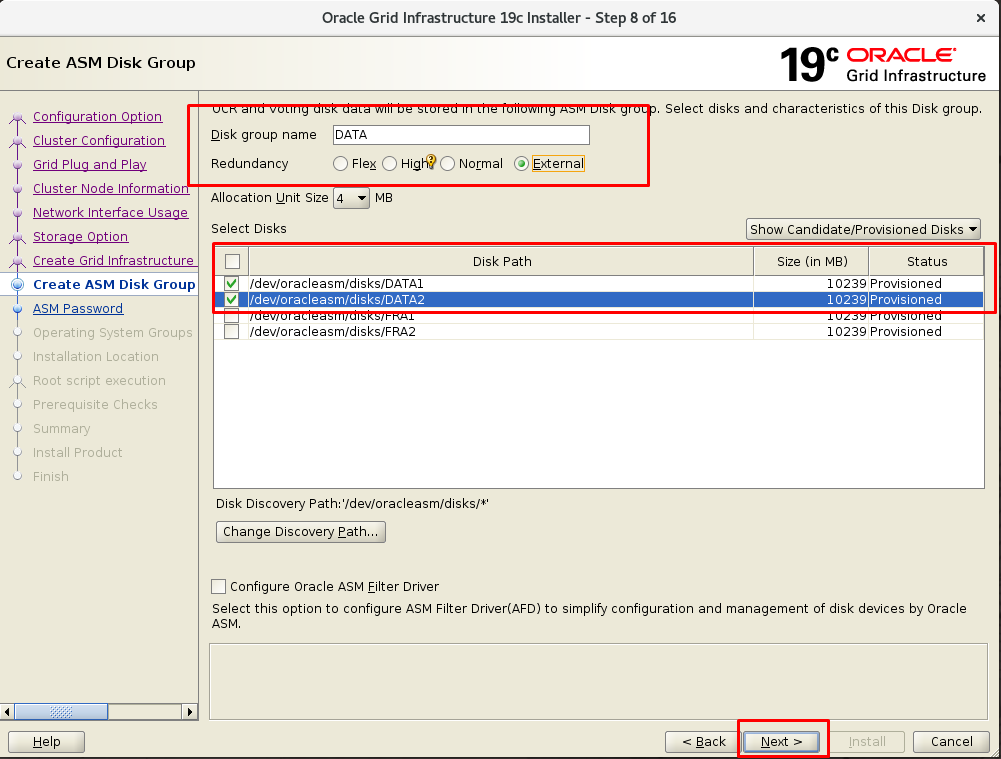

Şimdi disklerimizi ekleyeceğiz. Test kurulumu yaptığım için ” EXTERNAL ” seçeceğim.

+DATA alanı için hazırladığım DATA1 ve DATA2 disklerimi ekliyorum.

Grid üzerinde kullanılacak SYS ve ASMSNMP kullanıcıları ile şifre belirliyorum.

Oracle klasik olarak kurulumun son adımında root kullanıcısı ile script çalıştırır. Bu işlemi otomatik yapmasını istiyorsak bu alanı doldurabilir. Bu sayede kurulum esnasında root kullanıcısı bir script çalıştıracaksa bu otomatik yapılacak.

Bu adımda cvuqdisk paketi eksik olarak görülürse ,aşağıdaki işlemleri yapmanız gerekir.

# cd $GRID_HOME/cv/rpm

# CVUQDISK_GRP=oinstall; export CVUQDISK_GRP

# rpm -iv cvuqdisk-1.0.10-1.rpm

Sistem durumu kontrol ediliyor. Bende bazı eksikler buldu. Örneğin RAM yetmiyor çünkü minumum 12GB ram tavsiye edilmiş. Ben ” IGNORE ALL ” diyerek geçeceğim.

Oracle Database RAC için GRID kurulumu tamamlandı. Aslına bakarsanız en uzun ve zorlayıcı GRID kurulumu. Çok hassas noktaları mevcut. Örneğin NTP yanlış olursa problem çıkıyor. Cluster gereği her iki sunucunun saatinin eşit olması gerek. Bu sebepten temiz bir GRID kurulumu şart.

Sıradaki kurulum RAC üzerinde Database için olacak. Sonrasında testlerimizi yapacağız.

Tekrar görüşmek dileğiyle.